El Bus XT y el Bus ISA (AT)

El primero al salir al mercado comercial junto con el primer PC de IBM, fue

el bus XT al 1980, funcionaba a la misma velocidad que los microprocesadores

de la época, los 8086 y 8088, a 4.77 MHz; y su amplitud de banda era

de 8 bits. De aquí que con el 8088 se compenetraran perfectamente, pero

con el 8086 (ancho de banda de 16 bits) ya no había tanta compenetración

y surgió el concepto y el hecho de los "cuellos de botella".

El significado del acrónimo que nos indica su nombre es: Industrial Standard

Arquitecture, que traducido sería, Arquitectura Industrial Estandarizada.

Con la introducción del AT, apareció el nuevo bus de datos de

16 bits (ISA), y compatible con su antecesor. También se amplió

el bus de direcciones hasta 24 bits, la velocidad de señales de frecuencia

también se aumentó: de 4.77 MHz a 8.33 MHz. De nuevo nos encontramos

con un atasco de información entre la memoria y la CPU.

A las tarjetas de expansión incluso, se le asignaron una señal

en estado de espera (wait state), el cual daba más tiempo a las tarjetas

lentas para enviar toda la información a la memoria.

MCA (Bus Micro Channel)

En sí no es ningún tipo de bus, más bien es un sistema

de canalización, en el que los datos no son enviadas hacia al receptor

con una simple instrucción de direccionamiento si no que es éste,

el receptor, quién tiene que recogerlos. Para que esta tarea se lleve

a cabo, se ha de informar al receptor previamente con la dirección dónde

están los datos a recibir, y se le deja un camino (bus) libre para él,

para que transporte los datos libremente.

Surgió cuándo IBM trabajaba para crear una nueva tecnología

de bus, la sacó con sus ordenadores que incorporaban el PS/2, el MCA

(Micro Channel Arquitecture) permitía un ratio (transferencia de datos)

máximo de 20 Mb/s, por la nueva dirección de 32 bits, y el aumento

de velocidad a 10 MHz.

IBM incluyó un circuito de control especial a cargo del bus, que le permitía

operar independientemente de la velocidad del bus y del tipo de microprocesador.

Dentro este tipo de bus, la CPU no es nada más que otro dispositivo dónde

pueden ir y venir los datos. La circuitería de control, denominada CAP

(punto de decisión central), se enlaza con un proceso denominado controlo

de bus para determinar y responder a las prioridades de cada uno de los dispositivos

dominantes del bus.

Para permitir la conexión de más dispositivos, el MCA especifica

interrupciones sensibles al nivel, que resultan más fiables que el sistema

de interrupciones del bus ISA. de esta forma es posible compartir interrupciones.

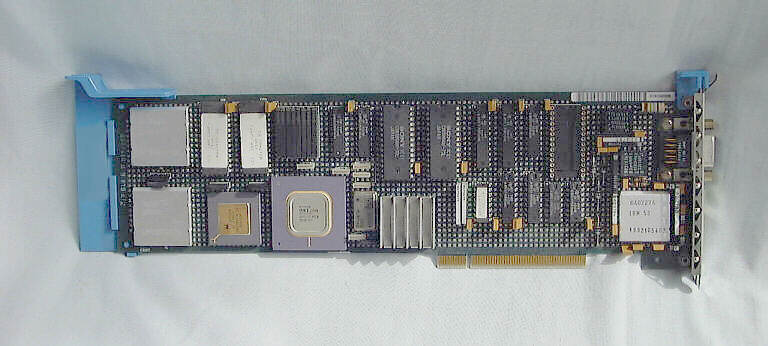

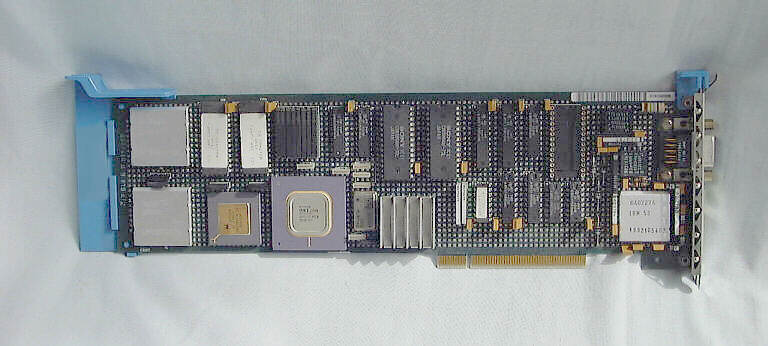

Esta estructura era completamente incompatible con las tarjetas de expansión

del tipo ISA, concretamente la diferencia que tenían una respeto del

otro se debía al tamaño de los conectores, más pequeños

a las del tipo MCA que las del tipo ISA.

EISA (Extended ISA)

Este bus es, tal y como nos indica su nombre (Enhanced Industrial Standard Arquitecture),

una extensión del primitivo bus ISA o AT. Tal y como hacía el

MCA, su bus de direcciones era de 32 bits basándose en la idea de controlar

un bus desde el microprocesador. Mantuvo la compatibilidad con las tarjetas

de expansión de su antecesor ISA, motivo por el cual tuvo que adoptar

la velocidad de éste (8.33 MHz).

Una de las ventajas que presentaba fue la de que era un sistema abierto, cantidad

de compañías contribuyeron a su desarrollo: AST, Compaq, Epson,

Hewlett Packard,, Olivetti, Tandy, Wyse, y Zenith.

Fue el primer bus a poder operar con sistemas de multiproceso (integrar al sistema

varios buses dentro del sistema, cada uno con su procesador).

Al igual que al MCA, incorporó un chip, el ISP Sistema Periférico

Integrado, encargado de controlar el tráfico de datos señalando

prioridades para cada posible punto de colisión o de bloqueo mediante

reglas de control de la especificación EISA.

Ni MCA ni EISA sustituyeron a su predecesor ISA, a pesar de sus ventajas, estos

representaban encarecer el coste del PC (a menudo más del 50%), y no

ofrecían ninguna mejora evidente en el rendimiento del sistema, y si

se notaba alguna mejora, tampoco era demasiado necesaria puesto que ningun dispositivo

daba el máximo de sí, ni en el bus ISA.

Local Bus

Vistos los resultados de los intentos fallidos para renovar y sustituir al bus

ISA, surgió este nuevo tipo de bus con un concepto de bus diferente a

todos los otros existentes, su mayor consolidación y aprovechamiento

lo tuvo en el área de las tarjetas gráficas, que eran las que

más desfavorecidas quedaron con los anteriores buses y velocidades.

Vesa Local Bus

VL no se arriesgó a padecer otro intento fallido como los de EISA o MCA,

y no quiso sustituir al ISA, sino que lo complementó. Por lo tanto tenemos

que para poseer un PC con VL, éste también tiene que tener el

bus ISA, y sus respectivas tarjetas de expansión, del VL en cambio, tendremos

una o dos ranuras de expansión, y son sólo estas las que son conectadas

con la CPU mediante un bus VL; de esta forma tenemos a cada sistema de bus trabajando

por su cuenta y sin estorbarse el uno al otro.

El VL es una expansión homogeneizada del bus local, que funcionaba a

32 bits pero podía realizar operaciones de 16 bits. El comité

VESA presentó la primera versión del VL-BUS en agosto del 1992,

y dado su completa integración y compenetración con el procesador

80486 se extendió rápidamente por el mercado.

Al presentar Intel su nuevo procesador Pentium de 64 bits, VESA empezó

a trabajar en la nueva versión de su bus, el VL-BUS 2.0.

Esta nueva especificación comprende los 64 bits posibles direccionables

del procesador, y compatibilidad con la anterior versión de 32 bits,

su velocidad y la cantidad de ranuras de expansión se aumentó

y se estableció en tres ranuras funcionando a 40 MHz, y dos a 50 MHz.

PCI (Peripheral Components Interconnect)

Este modelo que hoy en día rige en los ordenadores convencionales, y

es el más extendido de todos, lo inventó Intel y significa: interconexión

de los componentes periféricos.

Con la llegada de este nueve bus automatizado en todos sus procesos el usuario

ya no se tendrá que preocupar más de controlar las direcciones

de las tarjetas o de otorgar interrupciones. Integra control propio de todo

el relacionado con él: DMA, interrupciones, direccionamiento de datos.

Es independiente de la CPU, puesto que entre estos dos dispositivos siempre

habrá un controlador del bus PCI, y da la posibilidad de poder instalarlo

a sistemas no basados en procesadores Intel. Las tarjetas de expansión

se pueden acoplar a cualquier sistema, y pueden ser intercambiadas como se quiera,

tan solo los controladores de los dispositivos tienen que ser ajustados al sistema

anfitrión (host), es decir a la correspondiente CPU.

Su velocidad no depende de la de la CPU sino que está separada de ella

por el controlador del bus. Solución al problema del VL-BUS, dónde

las tarjetas debían aceptar la máxima frecuencia de la CPU o sinó

no podían funcionar.

El conector empleado es estilo Micro Channel de 124 pines (128 en caso de trabajar

con 64 bits), aunque sólo se utilizan 47 de las conexiones (49 en el

caso de tratarse de un conector bus-master), la diferencia se adeuda a las conexiones

de toma de tierra y de alimentación.

PCI es la eliminación de un paso al microprocesador; en vez de disponer

de su propio reloj, el bus se adapta al empleado por el microprocesador y su

circuitería, por lo tanto los componentes del PCI están sincronizados

con el procesador. El actual PCI opera con una frecuencia de 20 a 33.3 MHz.

Las tarjetas ISA no pueden ser instaladas en una ranura PCI convencional, aunque

existen equipos con un puente denominado <>. Consta de un chip que se

conecta entre los diferentes slots ISA y el controlador del bus PCI, su tarea

es la de transportar las señales provenientes del bus PCI capo al bus

ISA.

Su gran salida y aceptación fue en gran parte por su velocidad, así

el hardware se podía adaptar a la contínua evolución y

el incremento de velocidad de los procesadores.

SCSI (Small Computer System Interface)

Se origina a principios de los años ochenta cuando el fabricante de discos

desarrolló su propio sistema de E/S nominada SASI (Shugart Asociates

System Interface) que dado su éxito y su gran aceptación comercial

fue aprobado por ANSI al 1986.

SCSI no se conecta directamente a la CPU sino que utiliza de puente uno de los

buses anteriormente mencionados. Se podría definir como un subsistema

de E/S inteligente, cumplido y bidireccional. Un solo adaptador host SCSI puede

controlar hasta 7 dispositivos SCSI conectados con él.

Una de las ventajas del SCSI en frente a otros es que los dispositivos se direccionan

lógicamente en vez de físicamente, este sistema es útil

por dos razones:

1. Elimina cualquier limitación que el conjunto PC-Bios pueda imponer

a las unidades de disco.

2. El direccionamiento lógico elimina la sobrecarga que podría

tener el host al maniobrar los aspectos físicos del dispositivo, el controlador

SCSI lo controla.

Aunque varios dispositivos (hasta 7), pueden compartir un mismo adaptador SCSI,

tan sólo 2 de éstos pueden comunicarse sobre el mismo bus a la

vez.

Puede configurarse de tres maneras diferentes que le dan gran versatilidad:

1. Único iniciador/Único objetivo: Es el más común,

el iniciador es un adaptador en una ranura de un PC, y el objetivo es el controlador

del disco duro. Es una configuración fácil de implementar pero

no aprovecha al máximo las posibilidades del bus, excepto cuando se controlan

varios discos duros.

2. Único iniciador/Múltiple objetivo: Menos común y raramente

implementado, es bastante parecido al anterior excepto que se controlan diferentes

tipos de dispositivos de E/S. (CD-Rom y un disco duro)

3. Múltiple iniciador/Múltiple objetivo: Mucho menos utilizado

que los anteriores, se aprovechan a fondo las capacidades del bus.

AGP (Accelerated Graphics Port)

Fue creada por Intel para dar pie a la creación de un nueve tipo de PC,

al cual prestaron especial atención a los gráficos y la conectividad.

Basado en la especificación PCI 2.1 a 66 MHz, incluyó tres características

para el aumento de su rendimiento: operaciones de lectura/escritura en memoria

con pipeline, demultiplexado de datos y direcciones al propio bus, e incremento

de la velocidad hasta los 100 MHz ( el que supone un ratio de más de

800 Mbytes/s, más de cuatro veces que el PCI).

En su caso, como es un bus especialmente dedicado a los gráficos, no

tiene que compartir con otros dispositivos el ancho de banda; otra característica

de esta estructura es la de que posibilita la compartición de la memoria

principal por parte de la tarjeta gráfica mediante un modelo denominado

por Intel como DIME ( DIrect Memory Execute | ejecución directa a memoria),

la cual hace posible la obtención de mejores texturas en juegos y aplicaciones

3D, al almacenar estas en la RAM del sistema y transferirlas cuando las pidan

otros dispositivos.